前些天阿明看到一篇文章很有趣,叫《艾玛!X86基础架构生态圈也玩起了“细胞进化论”?》。阿明也来凑个热闹,浅谈浅谈X86生态进化论……

一个X86架构生态圈比作细胞进化,确实非常跨越行业。就在这之前,阿明在闪存峰会上碰见一位成都来京的修行者,不过他一边修行,一边研究前沿存储技术,他提到蛋白质存储介质,生物与存储技术看来还真有科学的关联,不过这方面的研究却是非常前沿。

就现在来说,“如果将整个基础架构领域也看做一个生态圈,那么早期的逻辑单点时代,大型机、小型机、X86服务器和存储就如同单细胞生物一样,都是单一独立的系统。而且单细胞生物统治了地球长达近30亿年的时间,逻辑单点时代不是也持续了很多年,才被今天的同质集群时代所更迭么?即单细胞进化到了多细胞时代。”

可见,X86的带来的行业进化也是有目共睹的,引发了生态多样性的爆发。

前些天,网上发了一张照片,1965年,IBM正在运送一台5M的硬盘,引发了微信朋友圈的相互转发。大家在感叹存储技术进步的同时,让阿明想到存储往往跟不上计算的摩尔定律节奏。

然而就在最近几年,软件技术的快速发展、闪存的出现与逐渐大规模应用之后,真正引发了存储领域的“基因突变”,存储与计算终于在摩尔定律下开始匹配。

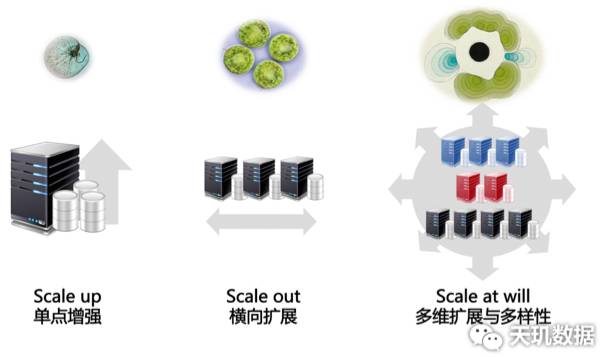

于是,X86架构与分布式存储,加上闪存的给力,带来了数据中心的新一轮进化。该作者在文章末尾的展望与评论中写道:不过最近几年软件定义技术发展势头迅猛,未来说不定由软件定义实现X86节点各种不同功能,于是基础架构生态圈新一轮多样性将全面爆发呢!而且此 “多样性”,如果用Scale at will来表达其内涵的话,已不是单纯的scale up, scale out或scale up + scale out“架构扩展方式”的多样性,而是基础架构拥有异质功能节点,可以弹性匹配不同领域发挥效用。正如同多细胞个体,因拥有异质单细胞,可以进行各种不同的生命活动一样。

Scale at will这个词阿明还是第一次听说,查了下资料,这种架构理念不仅深度融合了Scale Up与Scale Out优势,还给通用化的X86赋予了个性化的功能任务。

到底是什么意思呢?

Scale Up纵向扩展比较容易实现磁盘扩容,堆叠串接就可以了; 而Scale Out横向扩展表面上灵活,但要实现容量和性能提升必须同步增加节点数量,如果用户只想增加容量的话,那么付出采购整个节点的成本就不划算。而Scale at Will是一种全新的分布式架构,“在开放X86环境下,可实现按需配置节点资源,并支持逐节点在线平滑扩展。” 从而实现节点强壮度与系统弹性的最佳平衡。

同时,在X86的通用性支撑下,Scale at will在实现了Scale up与Scale out之外,还通过新的技术实现了第三维度的“Scale”——功能上的异质化扩展。今天的虚拟化、软件定义、分布式,以及以这些成熟技术为核心的超融合架构,使多个X86组合在一起,把他们资源拉通,可以自由流动,自由协同。这种底层平台化统一管理的实现,使标准X86设备从功能上进行多样化定制成为可能。

软件定义纵横融合,为用户提供真正灵活弹性的扩展能力,配置和部署管理也简单,资源利用率明显更高,在降低企业TCO(总体拥有成本)基础上更利于提升ROI(投资回报率)。

一张图下来,你就容易明白Scale at Will到底是什么了。

再回过来想想闪存应用、软件定义等技术的发展引发X86生态的突破性发展,“多个X86手拉手在一起,完成了之前大机小机做的事情。”

对此,阿明认为,一个新的时代确实已经来临。如何把握住X86架构更好的开放性,分布式存储的扩展与灵活性,闪存技术的高性能低延迟的加速,这其中的关键需要注意几点:

一是,如何形成X86架构下,计算、存储、网络的高效融合?“网络是数据跨空间传递,存储是数据跨时间传递。”如何解决好时空关联的问题,网络是关键,InfiniBand带来的网络加速又是一个新的境界。X86平台如果要发挥整体集群的性能,就需要高性能的网络,需要高带宽实现节点间数据大吞吐,需要低延迟提供高效的网络交互。InfiniBand的出现,基于交换网络的架构优势发挥到了很高水平,为大规模节点扩展带来了网络的支撑,目前其超高网络性能从10Gb/s起步直至60Gb/s,我们常见的单链路40Gb/s。

另外,在协议方面,Infiniband标准支持RDMA(Remote Direct Memory Access), “Infiniband构筑的服务器和存储器网络中任意一个服务器上的CPU可以轻松地通过RDMA去高速搬动其他服务器中的内存或存储器中的数据块。”当前几乎所有的网络协议,包括FC、IP/GbE、 NAS,、iSCSI等等都可以通过Infiniband网络整合到服务器中去。 Infiniband是FC性能的5倍,延迟是FC十分之一。这样也便于计算与存储性能的发挥。

二是,如何在超融合架构里面融入闪存加速的功能?闪存在超融合架构里面起到的作用,就是提升存储性能的同时,提升用户应用效能。特别是闪存卡在数据库加速、虚拟化启动风暴方面有着立竿见影的帮助作用。

三是,如何处理数据中断的情况?NVMe标准,已经给予了很好的优化,NVMe保障多个线程在每个核上都有自己的SSD队列并且不会被中断。能够确保多个CPU核心来处理IO中断,NVMe SSD则使用了内存,但是用于说明NVMe具有更少的主机CPU占用还是很合适的。

四是,再就是不同场景下用户需求不同,同时应用规模也使需求变得极致化,在这样情况下,超融合架构如何应对外部环境的多样化,也是需要思考的。

五是,分布式领域路人皆知的CAP理论,Consistency(一致性),数据一致更新,所有数据变动都是同步的;Availability(可用性), 好的响应性能;Partition tolerance(分区容错性) 可靠性,任何分布式系统只可同时满足二点,没法三者兼顾,如何取舍非常关键。

因此,阿明也非常认同这样的观点:“随着SAN架构日益成为系统扩展性能瓶颈,出现了Server SAN技术,其实就是让SAN重新融入服务器内部。再加上分布式、虚拟化、软件定义等技术的推动,基于X86平台的基础架构开始展现诸多新形态,例如时下最火的超融合架构,通过软件定义将基于X86标准硬件的计算、存储资源,以及网络和管理组件集成为一体化解决方案。”

来自用户方面的需求已经逐渐呈现出来了,并且表现得越来越强烈,那就是将自身现有的平台更好地对接云,最优越的选择就是转向X86平台。“Intel在2011年推出至强E7系列,在性能、可靠性方面已和小型机看齐。”虽然还有部分谨慎的用户并没有真正转向X86平台,犹犹豫豫的观望中,大家也通过用户成功部署与应用的案例意识到了X86平台的重要性。据阿明所知,包括运营商、银行、政府等领域的用户已经对X86平台有了更多的实践案例,至于在X86平台上实行一个什么样的部署方式,恐怕现在谈论最多的就是当前的超融合架构了。纵观全球与中国来看,超融合确实一直比较热闹,Nutanix在全球市场上不仅是超融合的领导者,而且引发了众多友商的跟进,比如SimpliVity、ScaleComputing,以及VMware的EVO:RAIL。在国内,较早进入超融合市场挑战Nutanix的,有华为、天玑数据等,2015年,又有不少厂商看到这个火热的市场,纷纷加入“游戏”,推出了超融合方案,如HP、青云等等。

“通过软件定义将基于X86标准硬件的计算、存储资源,以及网络和管理组件集成为一体化解决方案。”最终可以将节点定义为多重身份,这都是因为一个产品形态很难去满足用户所有需求,像国内的融合架构厂商天玑数据设计了三个形态的产品,将计算与存储融入标准X86服务器来满足市场需求,分别为针对数据库业务的PBData, 针对虚拟化场景的超融合架构PriData,以及可多维扩展的集群NAS系统PhegData。

不管怎么说,用户在实际应用过程中,一直非常看重几个方面的问题,包括供应商锁定、硬软件成本、服务支持成本、消除IT孤岛、资源灵活性等方面。如何将这些问题搞定,超融合架构之路似乎让大家把解决问题的办法看得更为清楚了。

可见,X86进化之后的最佳状态应该就是超融合了,那么超融合架构真的可以带来X86生态多样性爆发吗?

大家所认识的超融合架构就是采用通用的X86节点融合了存储、计算、网络、虚拟化平台(hypervisor),其中分布式存储架构,通过增加节点的方式横向扩容。如前文所述,如何给予用户更好的ROI,现在用户不仅关注软硬件的融合问题,投资回报率也是关键。当然对于那种不差钱的用户来说,也就无所谓了。

可见,众多节点组成一个整体,统一管理分配资源,要实现软硬件融合构成的一个整体解决方案,对于众多的厂商来说都比较容易,但难点在于如何针对用户应用环境的不同给予更有效的支撑以及更好的ROI。那么就非常有必要考虑到Scale Up与Scale Out纵横融合,通过软件定义将节点定义为多重身份,如前文提到的Scale at Will。

进一步分析来看,从生物学角度来说,单细胞进化为多细胞,因为基因突变,然后带来了生物进化的加速。数据中心架构也是一步一步进化而来,在闪存的加速下,数据中心发生了很大的变化。甚至X86已经独占行业主流,存储与计算的融合更为加强,超融合架构的作用下,对于用户私有云、数据库、数据存储与管理方面都带来了前所未有的改变。重点行业已经出现重点用户采用超融合架构+分布式替换小机+Oracle数据库的典型案例,以前这种情况不太可能发生,但现在已经成了现实。

高大上终于在X86大潮下失去了光色,一个新的时代正在开启。可以预见,超融合架构将主导许多用户未来的新部署新应用。(阿明)

欢迎关注阿明自媒体微信公众号:chinastor

本文来自残念投稿,不代表胡巴网立场,如若转载,请注明出处:http://www.hu85.com/171707.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 xxxxx@qq.com 举报,一经查实,本站将立刻删除。